線量率の直線性をチェックしました。

基準線源(Cs137 10MBq)と測定器の距離を変える事で線量を増減させ、基準値とGeoGamma220の測定値と比較しました。次のテーブルはその結果で、基準値は逆二乗法で求めた値、実測値は生の測定値です。基準値は測定室のバックグラウンド(0.11μSv/h)を含んだ値です。

| 基準値 | 実測値 | 補正値1 | 補正値2 | 補正値3 | 補正値3/基準値 |

| μSv/h | μSv/h | μSv/h | μSv/h | μSv/h | % |

| 1.0073 | 1.29 | 1.04 | 1.05024 | 1.000228 | 99.3 |

| 3.0175 | 3.38 | 3.13 | 3.206967 | 3.054254 | 101.2 |

| 5.099 | 5.46 | 5.21 | 5.408772 | 5.151212 | 101.0 |

| 10.4 | 10.5 | 10.25 | 10.9655 | 10.44333 | 100.4 |

| 29.97 | 27.2 | 26.95 | 31.70588 | 30.19608 | 100.8 |

| 52.216 | 42.5 | 42.25 | 53.99361 | 51.42249 | 98.5 |

| 81.59 | 61.1 | 60.85 | 86.00707 | 81.91149 | 100.4 |

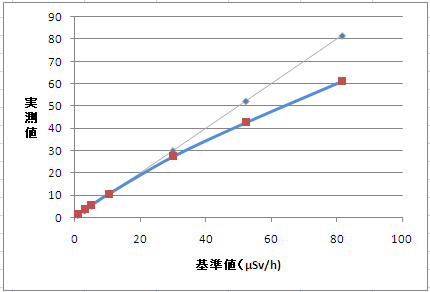

この基準値と実測値をグラフにしたのが次の図です。細い線はy=xのグラフで、青の線が実測値です。線量率が高くなるほどずれが大きくなっています。

次のグラフは基準値と実測値の比率で、線量率により直線性がどう変わるのかが分ります。

このグラフを見ると線量率が10μSv/h以下では、低くなるに従い実際より多めになっています。原因として考えられるのは基準線源の散乱線の影響です。線源からのガンマ線が床や壁に入射し、そこで反射されたガンマ線がディテクタに入射し、低線量率での誤差になっていると考えられます。その量は直接測定するのは難しいので、数値を適当に設定して計算すると、0.25μSv/hを差し引くと良くなりました。この値が上記のテーブルの補正値1です。なお、この0.25μSv/hは計算結果が合うように求めた数値であり、散乱線の影響が本当にそれだけあるのかは別の方法で確認する必要があります。

次に高線量率での誤差ですが、これはディテクタのDead Timeによりカウントされないためだと考えられます。ディテクタのDead Timeは別項で述べますが、4から5μsec程度です。そこで、Dead Timeの補正として (1-CPS * DeadTime) の式により補正します。ここでCPSはスペクトルのカウント値を合計して求めた1秒あたりのカウント数です。Dead Timeの実際の値としては4.5μsecにすると一番誤差が少なくなりました。この補正を行った後の数値が補正値2です。

この補正値2では全体に5%ほど値が高めなので、補正値2を1.05で割り、最終的な補正値3を得ます。以上の3項目につての補正を行った結果、直線性は1から80μSv/hの範囲で2%以内に収まりました。

なお、測定器としての補正はDead Timeによる補正と3番目の全体の値への補正の2項目を行う事になります。

今回のチェックでは線量率の上限は80μSv/hでしたが、グラフから見ると測定できる上限としては100μSv/hまでは行けそうな気がします。